Microsoft VALL-E 2: Sprachmodell zu gut fĂĽr die Welt?

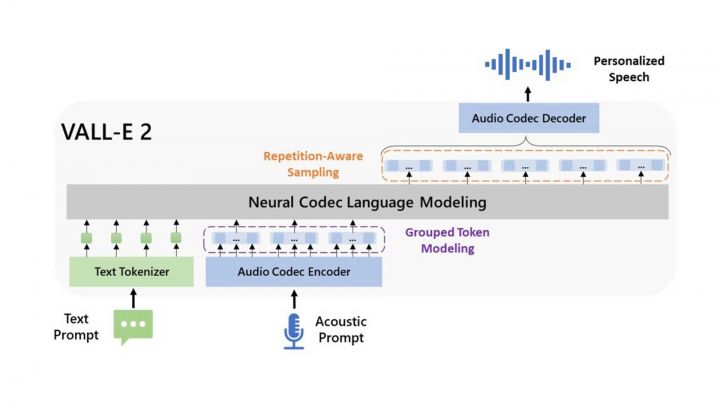

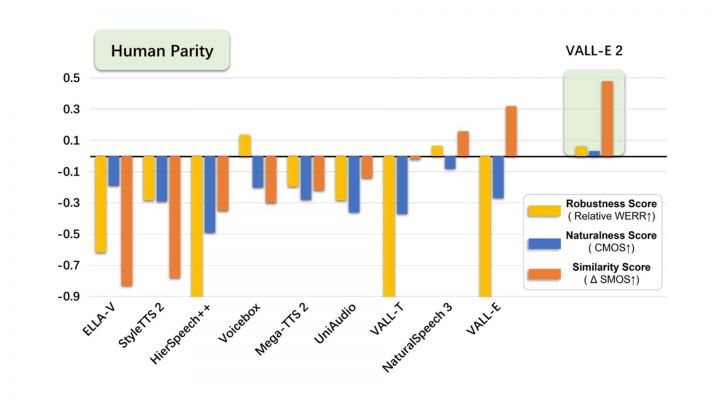

Aufbauend auf dem Vorgänger VALL-E führt die Weiterentwicklung als VALL-E 2 zwei Verbesserungen ein: Repetition Aware Sampling verfeinert das ursprüngliche Nukleus-Sampling-Verfahren, indem es die Wiederholung von Token in der Dekodierungshistorie berücksichtigt. Dadurch wird nicht nur die Dekodierung stabilisiert, sondern auch das in VALL-E auftretende Problem der Endlosschleife umgangen. Grouped Code Modeling organisiert Codec-Codes in Gruppen, um die Sequenzlänge effektiv zu verkürzen, was nicht nur die Inferenzgeschwindigkeit erhöht, sondern auch die Herausforderungen der Modellierung langer Sequenzen angeht. Microsoft bezieht sich dabei auf eigene Versuche mit den LibriSpeech- und VCTK-Datensätzen die gezeigt haben sollen, dass VALL-E 2 frühere Zero-Shot-TTS-Systeme in Bezug auf Sprachrobustheit, Natürlichkeit und Sprecherähnlichkeit übertrifft. Es ist das erste System seiner Art, das bei diesen Benchmarks die Parität zum Menschen erreicht. Darüber hinaus synthetisiert VALL-E 2 durchgängig hochwertige Sprache, selbst bei Sätzen, die aufgrund ihrer Komplexität oder sich wiederholender Phrasen traditionell schwierig sind.

Die gruppierte Codemodellierung soll nicht nur die Inferenz durch Verringerung der Sequenzlänge beschleunigen, sondern auch die Leistung verbessern, indem sie das Problem der Modellierung langer Kontexte entschärft. Basierend auf der Token-Wiederholung in der Dekodierungshistorie erhöht das wiederholungsbewusste Sampling die Stabilität des Dekodierungsprozesses und umgeht das Problem der Endlosschleife, das in VALL-E auftritt.

VALL-E 2 kann zwar mit einer Stimme sprechen, die der des Sprechers gleicht, aber die Ähnlichkeit und Natürlichkeit hängen von der Länge und Qualität der Sprachansage, den Hintergrundgeräuschen und anderen Faktoren ab. Dennoch, oder gerade deshalb dient die Veröffentlichung nur zu Forschungszwecken und es gibt keine Pläne, VALL-E 2 in ein Produkt zu integrieren oder den Zugang für die Öffentlichkeit zu erweitern. VALL-E 2 könnte Sprache synthetisieren, die die Identität des Sprechers beibehält. Nützlich könnte dies für Lernzwecke, Unterhaltung, journalistische Zwecke, selbst erstellte Inhalte, barrierefreie Funktionen, interaktive Sprachdialogsysteme, Übersetzungen, Chatbots usw. sein. Wer sich selbst davon überzeugen will, dem sei ein Blick auf die Projektseite empfohlen, wo es, natürlich in englischer Sprache, reichlich Hörbeispiele und Vergleiche gibt.

Human Parity bedeutet, dass die Robustheit, Natürlichkeit und Ähnlichkeitsmetriken von VALL-E 2 die der GroundTruth-Samples übertreffen. Damit soll VALL-E 2 akkurate, natürliche Sprache in der exakten Stimme des Originalsprechers erzeugen können und vergleichbar mit der menschlichen Leistung sein. Allerdings bezieht sich diese Aussage ausschließlich auf die experimentellen Ergebnissen der LibriSpeech- und VCTK-Datensätze.

Doch Microsoft sieht selbst die Gefahr, dass das Modell missbraucht wird, z. B. zur Fälschung der Stimmerkennung oder zur Nachahmung eines bestimmten Sprechers. Man betont, dass man die Experimente unter der Annahme durchgeführt hat, dass der Benutzer zustimmt, der Zielsprecher in der Sprachsynthese zu sein. Um dieses Sprachmodell wirklich zu veröffentlichen und auf unbekannte Sprecher in der realen Welt anwendbar zu machen, sollte es ein Protokoll enthalten, das sicherstellt, dass der Sprecher der Verwendung seiner Stimme und eines synthetischen Spracherkennungsmodells zustimmt, meint Microsoft.

KI in der Videoproduktion: passende Tools und wichtige Tipps

NewsĂĽbersicht: Kamera

Link zum Hersteller: Microsoft - VALL-E 2